Samsung SOCAMM2 apunta a la IA a gran escala con memoria desmontable, más del doble de ancho de banda y un 55 % menos de consumo

por Manuel NaranjoEn un centro de datos, la IA ya no es un trabajo puntual. Es una carga continua que consume electricidad, genera calor y obliga a optimizar cada parte del servidor. Y en esa optimización hay un sospechoso habitual: la memoria. Puedes tener aceleradores potentísimos, pero si se quedan esperando datos, el sistema pierde rendimiento y también pierde dinero.

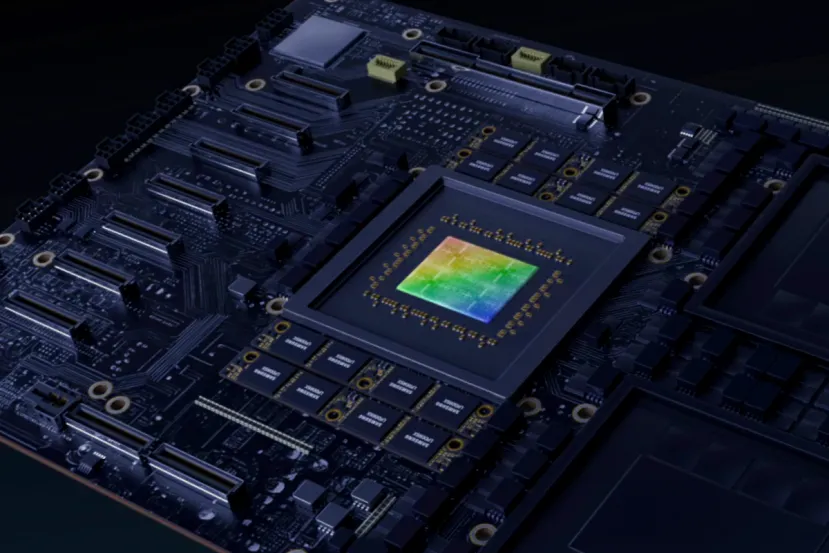

Por eso Samsung ha anunciado SOCAMM2, un módulo de memoria pensado para servidores de IA. El objetivo es fácil de entender: más ancho de banda con menos consumo y un formato que facilite el mantenimiento. Samsung dice que ya está enviando muestras a clientes y que trabaja con NVIDIA en la optimización, mientras participa en esfuerzos de estandarización con JEDEC.

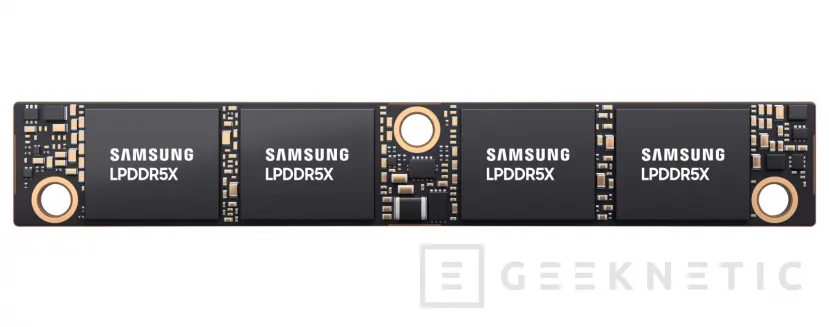

SOCAMM2: LPDDR5X con enfoque de servidor

SOCAMM2 significa Small Outline Compression Attached Memory Module. Samsung lo construye sobre LPDDR5X y lo orienta a plataformas aceleradas donde el rendimiento por vatio manda. En su planteamiento, no pretende borrar del mapa a la memoria clásica, como RDIMM, sino ofrecer una alternativa para sistemas de IA con limitaciones térmicas más duras.

Samsung afirma que SOCAMM2 ofrece más del doble de ancho de banda frente a un RDIMM tradicional y un consumo un 55 por ciento menor. Si esto se mantiene en producto final, es un cambio directo en la métrica que hoy manda en IA: rendimiento por vatio.

El porqué es simple: la GPU necesita que la memoria le alimente sin pausas. Si el flujo se atasca, baja la utilización real y el rendimiento efectivo se queda por debajo de lo que pagaste. Y el consumo menor tiene una segunda derivada: menos calor. Reducir calor significa aliviar ventilación, simplificar refrigeración y sostener el rendimiento durante más tiempo.

Diseño desmontable: la solución a la pega clásica de LPDDR

LPDDR suele implicar memoria soldada a la placa. Es compacto, sí, pero es un problema para mantenimiento y ampliaciones. SOCAMM2 se presenta como desmontable, permitiendo reemplazar o actualizar la memoria sin modificar la placa base.

Samsung lo vincula al TCO, el coste total de propiedad. Menos tiempo de intervención y menos paradas se traducen en ahorro real, y en centros de datos ese ahorro es igual de importante que el rendimiento.

Orientación horizontal y espacio mejor aprovechado

Samsung destaca que SOCAMM2 adopta una orientación horizontal frente a la disposición vertical típica de RDIMM. Esto ayuda a aprovechar mejor el espacio, facilita colocar disipadores y permite diseñar el flujo de aire con más libertad, algo crítico en servidores densos con CPU, aceleradores y memoria muy cerca.

La compañía también menciona compatibilidad con refrigeración por aire y por líquido. Un formato que no obligue a rehacer toda la plataforma tiene más opciones de adoptarse, porque el mercado está mezclado entre ambos enfoques.

NVIDIA y JEDEC: convertirlo en algo adoptable

Que Samsung hable de cooperación con NVIDIA y de estandarización con JEDEC no es postureo. Para que un formato de memoria prospere, el ecosistema necesita reglas comunes. Si JEDEC fija guías, fabricantes e integradores pueden moverse con menos riesgo y más compatibilidad entre plataformas.

NVIDIA podría necesitar alrededor de 20.000 millones de gigabytes de SOCAMM2 en 2026, y Samsung podría suministrar aproximadamente la mitad, unos 10.000 millones de gigabytes. Para llegar a ese volumen, se menciona una necesidad de entre 30.000 y 40.000 obleas al mes.

Las cifras pueden moverse, pero el mensaje es claro: SOCAMM2 se plantea como producto de volumen para la infraestructura de la inteligencia artificial que viene. Y si el volumen se confirma, también se entiende por qué la estandarización y la compatibilidad importan tanto.

Por qué importa fuera del datacenter

Si una consulta de IA cuesta menos energía y menos refrigeración, es más fácil escalar servicios como traducción, búsqueda, asistentes o edición. SOCAMM2 apunta justo a eso: alimentar aceleradores con más ancho de banda, recortar consumo, bajar calor y facilitar el mantenimiento.

En el fondo es una pieza de infraestructura, de las que no se ven, pero que determinan cuánto cuesta ofrecer IA a gran escala. Cuando una plataforma necesita menos vatios para mover el mismo volumen de datos, hay margen para meter más nodos por rack o para mantener la potencia sin ampliar tanto la sala de refrigeración. Y eso acaba notándose en precios y disponibilidad.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!